夕陽リリの統語論

ごさいようじょです。これは怪文書です。

はじめに

夕陽リリちゃんというVTuberがいます。

特徴としてはめちゃくちゃ可愛いくて、イケメンで、笑顔が素敵で最高といった感じです。

2018年8月現在、VTuberランキングで1位となっています。VTuberランキング

そんな夕陽リリちゃんが主に最近のMirrativ配信においてコメントを拾う際の話題転換*1に、一定の法則が存在することを示唆する結果が得られたので報告します。

報告

夕陽リリちゃんの話題転換はそのほとんどが以下に挙げるパターンに則っています。

以下において上位にあるほど出現頻度が高く、下位のパターンは1配信に1度現れないレベルで稀なものとなっています。

- えーっと~ ⇒ んっんー ⇒ (本題) (圧倒的。半数を占める)

- んっんー ⇒ えーっと~ ⇒ (本題)

- えーっと~ ⇒ (本題) (ここまでで約7割を占める)

- んっんー ⇒ (本題)

- んん゛ー ⇒ (本題)

- えーっと~ ⇒ (間) ⇒ んん゛ー ⇒ (本題)

- えーっとっ ⇒ (間) ⇒ (本題)

- ん゛んー ⇒ えーっと~ ⇒ (本題)

- (間) ⇒ (ゲラ) ⇒ (本題) (主にコメント返しにおいて次のコメントが面白い場合)

- ん゛ん゛~ ⇒ (間) ⇒ んっんー ⇒ (本題)

- (思い出し・引きずりのゲラ) ⇒ 取り繕う「んっんー」 ⇒ (本題)

- δ*2 ⇒ (本題)

- んしょっ ⇒ (本題) (おそらく体勢を整えている)

- (突然のゲラ) ⇒ 「いや違うんだよ!」など ⇒ (本題) (目に入ったコメントがあまりに面白かった場合。しばしば話題の中断を伴う。)

- んーーーー ⇒ (間) ⇒ (本題)

- (はい) 次 ⇒ んっんー ⇒ (本題) (マシュマロの際はこちらが基本だがコメ返しでは稀)

- えーーーーーー ⇒ (間) ⇒ んっんー ⇒ (本題)

マシュマロ拾いではこれらの第一・第二のプレースホルダに「はい次 ⇒ (んっんー OR えーっとっ)」などが入ることによっておおよそカバーされます。 *3

この結果から夕陽リリちゃんの殆どは通説通り「んっんー」で構成されていることがわかるのですが、重要な点としてこれらはランダムに発生するものではないということがあります。

例えば基本となる間延びした「えーっと~」の派生として、キレの良い「えーっとっ」があるのですが、これは「んっんー」とは同時に生起しません。

また、生理学的な説明がつくと思われるのですが、「んっん~」より喉の調子が悪いであろう「んん゛ー」は微妙な間を含む事が多いです。

こうした現象についてさらなる考察を深めてゆくことは、リリちゃんの口からは多くをうかがい知ることが出来ない未来人の生態の解明の大きな一助となることでしょう。

情報をお待ちしております。

今後の課題

おわりに

夕陽リリちゃん、端的に言って最高なので皆さんチャンネル登録をお願いします。

obの関手性

ごさいようじょです。これはMathjaxのテストです。

$\mathcal{C}$を局所小圏、$\textbf{Cat}$を局所小圏とその間の関手の圏とします。

このとき圏論的な対象への対応$\text{ob}$は関手 $\text{ob}: \textbf{Cat} \rightarrow \textbf{Set}$として振る舞います。

具体的には$\text{ob}$を

\begin{align}

&(対象)~\forall \mathcal{A} \in \textbf{Cat}, \\

&~~\text{ob}(\cdot)(\mathcal{A}) = \text{ob}(\mathcal{A})\\

&(射) ~ \mathcal{A} \xrightarrow{\forall F} \mathcal{B}, \forall A \in\mathcal{A},\\

&~~\text{ob}(F)(A) = F(A)

\end{align}

と定義します。

これは$\mathcal{A} \in \textbf{Cat}$の対象を、各々の小圏の対象に関する関手(の二つ組の片割れ)を保存し、その射$\text{ar}(\mathcal{A})=\{A \xrightarrow{f} A' ,~\forall A, A' \in \mathcal{A}\}$の対応を忘却するような感じで$\textbf{Set}$に写す対応になっています。

(忘却関手と言えそうな感じがする)

proof

(恒等射の保存)

$\forall \mathcal{A} \in \textbf{Cat}$に対して恒等関手を$1_\mathcal{A}$とします。

このとき$A \in \text{ob}(\mathcal{A})$に対して

\begin{align}

\text{ob}(1_\mathcal{A})(A) &= 1_\mathcal{A}(A) &\qquad (\text{ob}の定義) \\

&= A&\\

&= 1_{\text{ob}(\mathcal{A})}(A)

\end{align}

より $\text{ob}(1_\mathcal{A}) = 1_{\text{ob}(\mathcal{A})}$ がいえます。

(合成射)

$ \mathcal{A} \xrightarrow{\forall F} \mathcal{B} \xrightarrow{\forall G} \mathcal{C}$とします。

このとき合成関手$G \circ F, ~\forall A \in \mathcal{A}$にたいして

\begin{align}

\text{ob} (G \circ F)(A) &= (G \circ F) (A) &\qquad (\text{ob}の定義)\\

&=(\text{ob}(G) \circ \text{ob}(F))(A) &\qquad(対象に対して\text{ob}(F) = Fなので)

\end{align}

よって$\text{ob} (G \circ F) = \text{ob}(G) \circ \text{ob}(F)$.

なのでobは局所小圏に対して関手$\mathbf{Cat} \rightarrow \mathbf{Set}$を定めることがわかりました*1。

自然に出てきた対象への対応$\text{ob}$が実は関手的であったというのはおもしろいですね。

とても童心をくすぐるものだと思います。

*1:これ、局所小圏じゃなくて大きな圏の場合には関手にはならないんですかね。 $\text{ob}: \textbf{CAT} \rightarrow \textbf{Cls}$? $\textbf{Cls}$なんてあるのか…?

日本ディープラーニング協会ジェネラリスト検定 受験記

============= 追記: 2018-07-05 =============

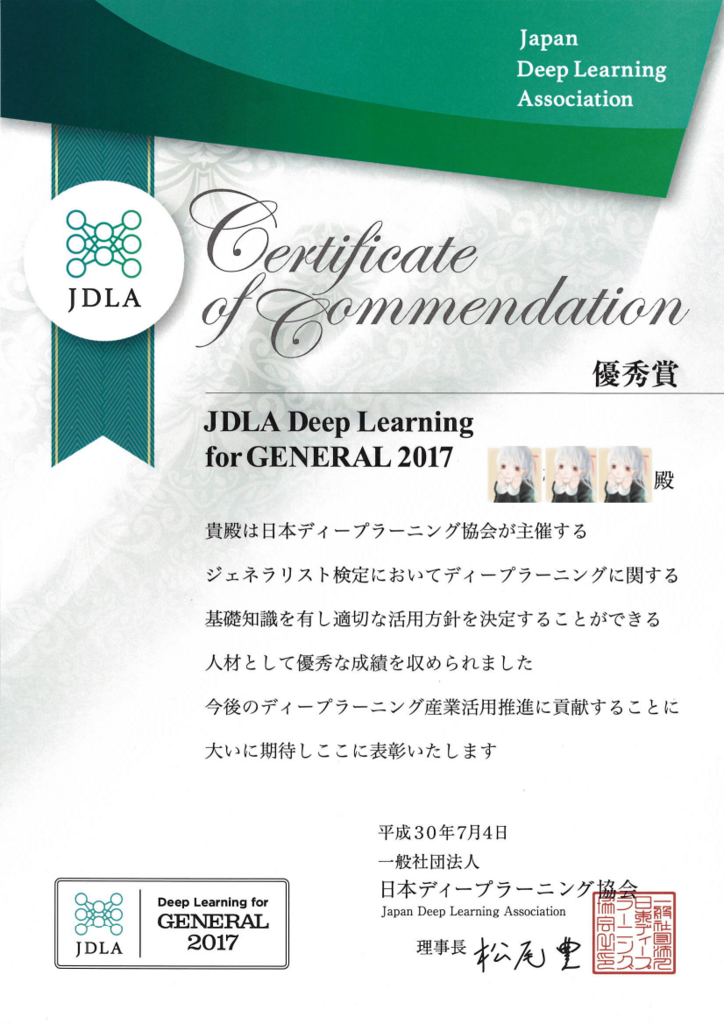

去る2018/07/04、株式会社FiNCで行われた「G検定合格者の会」にて、第一回試験の成績優秀者として表彰をいただきましたので報告します。

合格者の会、立ち消えになったのかなと思っていたのですが第2回検定と一緒にやるというお話で、「成績優秀者として表彰する。タダで美味いもの食わせてやる。」というご招待のメールを頂き、女児の身で僭越ながら参加させていただきました。

勉強不足のためか残念ながら最優秀賞は逃してしまいました。 しかし、話を聞く感じ皆さん真面目に時間いっぱい使って受けられておられたようで、後述のように1時間せずに回答を終えた不届き者は見受けられませんでした。 その点で私はほぼ間違いなく「時間あたりの得点効率」において圧倒的勝利を収めることができたのかなと思います。満足です。

一点解せないのは「最年少合格者の表彰」があったのですが、ごさいであるところの私が表彰対象でなかったことです。おそらくごさいはあまりにも幼すぎるためバリデーションで弾かれてしまったのかなと察するところであります。残念です。

ブログと紐付いて合格取り消しとかになるとイヤなので名前は伏せています。

=========== 追記ここまで ===========

ごさいようじょです。

2017年12月16日、第一回目の実施となる日本ディープラーニング協会(JDLA)ジェネラリスト検定(G検定)を受験し、

本日26日、無事に合格判定を頂きました。

得点は~~~満点中**点でした。(これは観測され次第状態が定まる不思議な文字列です。しばしお待ちください。) *1

せっかくなので受験記をここに記したいと思います。

ここで、このエントリの内容は単に個人の感想であり、記載された以上の内容、例えば筆者の気持ちなどを推し量り、見出してはなりません。 ご了承ください。

プロフィール

「東大受験記」、「オラクルマスター受験記」的な記事をみる感じ、受験記の最初にはプロフィールを書くらしいのでやります。

上は適当なこと書いてありますが、実際のところ私は情報系の人間ではないものの、ここ2~3年ほど流行りに乗ってディープラーニングやら、その周辺領域の研究をしている女児です。

ただ専門的にはILSVRCでAccuracy勝負をするようなガチガチのディープラーニング屋ではなく、どちらかと言えばトラディショナルなニューロ屋とか横断領域の人間といったほうがおそらく適切かと思います。

少なくともDeep Learningという言葉を多用する世界線には居ません。

deep neural networks, recently known as deep learning ですかね。

推薦図書

よく知らなかったのですが、検定には推薦図書とやらがあったそうです。

読了状況は以下になります。

AI白書 2017

IPAからこんな本出てたんですね。知らなかったです。

後述しますがよくわからなかった問題はこの本から出てたのかな、と思います。

人工知能は人間を超えるか ディープラーニングの先にあるもの

- 作者: 松尾豊

- 出版社/メーカー: KADOKAWA / 中経出版

- 発売日: 2015/03/10

- メディア: Kindle版

- この商品を含むブログ (29件) を見る

松尾先生が書かれた本らしいです。キャッチーなタイトルですね。

Kindle版が500円しないらしいので今度暇なときに読んでみます。

深層学習 機械学習プロフェッショナルシリーズ

- 作者: 岡谷貴之

- 出版社/メーカー: 講談社

- 発売日: 2015/04/08

- メディア: 単行本(ソフトカバー)

- この商品を含むブログ (13件) を見る

読みました。当然です。俗に言う青本/岡谷本ですね。言うまでもなく良書です。

ちなみに青本というと、もう一冊の深層学習に関する良書も、人工知能学会誌の特集を集めたやつも「青本」なので紛らわしいところです。

- 作者: 麻生英樹,安田宗樹,前田新一,岡野原大輔,岡谷貴之,久保陽太郎,ボレガラダヌシカ

- 出版社/メーカー: 近代科学社

- 発売日: 2016/02/01

- メディア: Kindle版

- この商品を含むブログを見る

蛇足ですが、深層学習にとっつくのは最初は下のJSAIの青本のほうが網羅的で、歴史的なところとかそういうのもきちんと書いてあって個人的にはオススメです。

ただ簡潔かつ密度高く書かれていて少々わかりにくいところもあるので、そこは軽く読み飛ばして、岡谷先生の本を読んでもう一回戻ってくるのがよいと思います。

まあ最初に「よく知らなかったのですが」とか言ってる時点でそういうことです。舐めプはやめましょう。

ちなみにこういう書評みたいの、「あふぃりえいと」っていうのをやるとすごく儲かるって聞いたんですけど誰か教えてください。

勉強方法

試験対策的な勉強は一切していませんが、(国語の)作文とか(お遊戯会の)発表をするときに必要になるので、AIの歴史的側面みたいなものはなんとなく抑えています。

研究のスコープ的にはコンピュータビジョン屋なので、CV系の話についてはある程度は最近の研究なんかも追えているつもりです。

一方で強化学習周りや、特に自然言語処理の周辺はからっきし(小耳に挟む程度)なので、そのへんは素直に勉強が足りなかったな、どう考えたってやるべきだったよなと思います。

いえ普通に舐めプでしたすみません許してください何でもしますから

所感など

まず試験の難易度について、舐めプしといてなんですが普通に高かったと思います。

合格率は60%を切っており、休日のオンライン受験で受験率は高いであろうことを鑑みると、まあなかなかといったところですね。

受験形式は多岐選択式で、出題数は当初の予告は100問とのことでしたが、実際は 中問が 100問で小問は230問とかそのくらいあってびっくりしました。

内容としては、 あんまり言うと怒られそうなのでぼかしますが、出題範囲は

- AI研究の歴史

- 産業界へのディープラーニングの応用事例

- 機械学習技術の概要(SVM, ロジスティック回帰とかなんとか)

- ディープニューラルネットの基本的な数理

- CV・NLP・RLなどへの応用

- AIと法・倫理とか

- などなど

例えば

- AIに関する文章穴埋め

- この関数を偏微分せよ

- 一層のパーセプトロンの順伝搬を求めろ

- 深層学習フレームワークとその特徴について(Caffe, chainer, Torch, Tensorflow+Keras)

- Google, Amazon, Apple, Microsoft, nVidiaなどのAI分野への取り組み

- 学習済みモデルの権利に関する法律

とかとか、いや書いてみて思いましたが、本当に多岐にわたっていました。

法律とかそういうよくわかんないのはAI白書に書いてあるっぽいですね。

設問内容に関して特に、2017年の

[1706.00712] Convolutional Neural Networks for Medical Image Analysis: Full Training or Fine Tuning?

で触れられている内容について問う問題があって、結構おおっと思いました。

なかなかナウいですね。イケてますよ。

個人的な出来としては、その辺のテクノロジ的な所はよいとしても、

それ以外のジェネラリストっぽい「人工知能」然としたところ(シンギュラリティーについてこんな有名人が〜〜と言ったとか 知らねえよ)とか、AIに関する法律みたいなところは本当にボロボロでchance levelくらいの正答率しかないと思います。

それでも一応合格はいただくことができたので、合格ラインはまあ普通に6~7割のあたりではないかな、と推測します。

細かい部分を問われる問題も多かったですが、設問全体を通して特に強調されていたのが

「AI(DNN)を実応用するにあたって最も重要なのは、AIに何ができて何ができないのかをしっかり認識すること」

ということでした。

これに関しては、本当の本当に、全く以って、心の底から、全力で共感することであり、このことが共通認識となってくれるだけで人工知能技術の実社会応用の推進の助けになると思いますし、何より実際に問題に取り組む理系職が、このブームの中で無茶振りに揉まれて死んでゆくのを止めることができるのではないかな、と思います。

設問の細かなところには首をかしげるところも皆無とは言えなかったのですが、上のメッセージを広く・強く伝えてくださるだけでも十分な価値ある検定試験だと思います。

受験のアドバイス

当該分野についてバリバリ業務で使っていたり、今red oceanの中で絶賛泳ぎ回っている方を除いて、ノー勉は普通に無謀だと思います。

とはいえこの範囲をずぶの素人の方が全部カバーするのもなかなか難しいと思うので、指定図書をざっと読んで、エンジニアの方はモデルの内容とか数理的なバックエンド、

営業とかコンサルの方は歴史、法律、応用事例とかそういうのにフォーカスして 確実に8割取りに行く つもりで臨むのがよいと思います。

合格すると名刺にJDLA Generalistって書いていいらしいのでがんばりましょう。

おわりに

無事合格してよかったです。

門外漢の方が落ちてもまあ、ですが、ようじょの場合ド専門なのでシャレになりません。